英特爾在自己最擅長的 CPU 上完成了一次 AI 計算的革新。

人工智能技術改變了我們的生活,而說到 AI 背后的算力,人們經常會先想到 GPU。從 2019 年英特爾為其第二代至強可擴展處理器增添了內置的深度學習加速技術后,原本定位通用計算的 CPU 芯片,也加入了為 AI 加速的行列。

今天,代號為「Sapphire Rapids」的第四代至強可擴展處理器也在中國迎來發布首秀,除了一系列微架構的革新和技術規格的升級外,新 CPU 對 AI 運算「更上層樓」的支持也格外引人關注,其背后的技術助力,也是英特爾在這代產品中增添的全新內置 AI 加速器 —— 英特爾高級矩陣擴展(AMX)技術自然也成為了焦點。

作為焦點,當然要拿出實力來證明自己的價值 —— 在發布會上,英特爾透露的第四代至強可擴展處理器的基礎算力平均提升值為 53%,而在 AMX 的助推下,其在 PyTorch 上的 AI 實時推理速度,可提升至上一代產品(FP32)的 5.7-10 倍,訓練性能提升最高也能提升到上一代產品的 10 倍…… 這意味著,這款新至強,把業界頂級 CPU 的性能門檻一下子提高了不少。

新一代英特爾 CPU 為 AI 任務處理找到了新方向。現在,英特爾可以通過新 CPU 和 GPU 實現對各類 AI 任務的加速。為實現這些提升,英特爾引入了一系列內置加速單元。

多種加速器加持,提升 AI 訓練、推理及端到端性能

AI 的熱度,從 AlphaGo 一鳴驚人后,一直就沒有減退。最近一段時間,人們都在談論 ChatGPT 等「大模型」帶來的革命性體驗。由預訓練模型方法推動的 AI 技術正在向跨任務、跨模態的方向演進,已成為當下 AI 技術發展的重要趨勢。

然而,大模型雖然帶來了前所未有的 AI 能力,又對算力提出了無窮無盡的需求。芯片制造商和科技公司一直在尋找提升 AI 應用效率的方法。GPU 更多解決的,是訓練效率,是探索 AI 算法邊界的能力,而 CPU,似乎更適合在 AI 應用的規模化部署和實踐上發揮重要作用。

自從四五年前開始在 CPU 中內置針對 AI 進行加速的專用運算單元或指令集后,英特爾就一直相信,如果想要在更為廣泛的行業中真正推進 AI 應用的普及,那么就應該充分利用現階段應用和部署最為廣泛的 IT 基礎設施和架構,也就是要更加充分地利用 CPU 的資源。畢竟使用 GPU 和其他專用加速器的成本以及知識和人才門檻都非常高。相比之下,CPU 內置 AI 加速能力,主攻 AI 推理加速,并搭配以更為簡單易用、能夠部署和優化難度的軟件工具,會是一條更為行之有效的路徑。

它是這么想,也是這么做的 —— 首先,從 2017 年第一代至強可擴展芯片開始,英特爾就開始利用英特爾高級矢量擴展 512 技術(AVX-512 指令集)的矢量運算能力對 AI 進行加速上的嘗試,到 2018 年英特爾在第二代至強可擴展芯片導入深度學習加速(DL Boost)技術,更是讓至強成為了首款集成 AI 加速有力的主流數據中心級 CPU,或者說:CPU 加速 AI 的代名詞。

2020 年通過擴展出 bfloat16 加速功能,面向多路服務器的第三代至強可擴展處理器在推理加速能力之外,又增加了訓練加速能力,已被證明可以幫助業界大量 AI 工作負載實現更優的性能和功耗比。

就在大家認為英特爾在 CPU 加速 AI 的技術創新和投入會止步于此的時候,第四代至強可擴展芯片,又帶來了矩陣化的算力支持 ——AMX。

第四代英特爾至強可擴展處理器

這種全新內置 AI 加速器的出現,進一步驗證了「與其增加 CPU 內核數和時鐘頻率,加入和更新專用計算單元對提升 AI 工作負載性能更有效」這一思路。正如前文所述,第四代至強可擴展芯片不僅可借助 AMX 實現相當于上一代芯片(FP32)10 倍的 AI 性能提升,與前兩代產品使用的深度學習加速技術相比,其理論性能(每秒操作量)最高也可以達到其 8 倍之多。

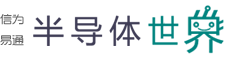

機器學習包含大量的矩陣計算,在主打通用計算的 CPU 上,此類任務會被轉換為效率較低的向量計算,而在加入專用的矩陣計算單元后,至強 CPU 的 AI 能力有了巨大的提升。因此,AMX 可以被視為至強 CPU 上的「TensorCore」—— 從原理上看,CPU 上的 AI 加速器實現的目的和 GPU、移動端處理器上的類似。由于 AMX 單元對底層矩陣計算進行加速,理論上它對于所有基于深度學習的 AI 應用都能起到效果。

如果說 AMX 為至強 CPU 帶來的是直觀的推理和訓練加速,那么第四代至強可擴展芯片內置的其他幾種加速器,就是為 AI 端到端應用加速帶來的驚喜。

這是因為在真正完整的 AI 應用流水線中,任務往往會從數據的處理和準備開始,在這一階段,第四代至強可擴展芯片內置的數據流加速器(DSA),可讓數據存儲與傳輸性能提升到上一代產品的 2 倍,而專門針對數據庫和數據分析加速的英特爾存內分析加速器(IAA),也可將相關應用的性能提升到上一代產品的三倍(RocksDB);數據保護與壓縮加速技術(QAT),則能在內核用量減少多達 95% 的情況下將一級壓縮吞吐量提升至原來的兩倍。這些技術的使用,也有助于 AI 端到端應用性能的整體躍升。

此外,隨著 AI 應用在更多行業,包括金融、醫療等數據敏感型行業的落地,人們對于數據安全合規的要求逐漸提高,聯邦學習等技術逐漸獲得應用。在這一方面,至強可擴展處理器集成的專攻數據安全強化的加速器 —— 軟件防護擴展(SGX),也是大有用武之地,它的突出優勢就是可以為處理中或運行中的敏感數據和應用代碼提供與其他系統組件和軟件隔離的安全飛地,實現更小的信任邊界。

這種技術對于 AI 而言,最核心的價值就是可以讓有多方數據交互、協作的 AI 訓練過程變得更加安全,各方數據都可以在其擁有者的本地參與訓練,用于訓練的數據和模型會被安全飛地所保護,最終模型可以在這種保護下提升精度和效率,但為其演進做出了關鍵貢獻的數據則會一直處于「可用而不可見 」的狀態下,以確保其中的敏感和隱私信息的安全性。

在這么多內置加速器的支持下,可以說,從數據預處理,到訓練,再到推理,最后到整個 AI 應用的安全保護層面,第四代至強可擴展處理器都實現了更全面的功能覆蓋和重點增強。與此同時,英特爾還在進一步強化 AI 加速的開箱即用優勢:通過與大量第三方進行合作,英特爾共同優化了 SAP HANA、Microsoft SQL Server、Oracle、VMware Cloud Foundation、Red Hat OpenShift 等主流應用,很多主流軟件庫和開源機器學習框架,以及大多數云服務也對這款英特爾架構上的新品做好了優化,開發者可以直接使用新硬件開發和部署 AI 算法。

從開發者的角度看,使用第四代至強可擴展處理器實現優化加速的門檻也確實很低:人們只需使用集成在 TensorFlow 和 PyTorch 中的庫,無需任何額外工作即可激活至強芯片內置 AI 加速的能力。此外,只需更改幾行代碼,開發人員就可以無縫地加速單節點和多節點配置中的 Scikit-learn 應用。

全能服務器 CPU

除了有加速器傍身專攻特定應用負載外,第四代至強可擴展處理器在基礎性能上也是可圈可點。

例如,它采用了與英特爾第 12、13 代酷睿同款的 Intel 7 制造工藝(改進版 10nm 制程)和 Golden Cove CPU 架構,同時首次引入 chiplet 小芯片封裝方式,最多可搭載 60 個核心,改用新的 Socket E LGA4677 封裝接口,集成了 112MB 三級緩存,功耗最高達到 350W。

新一代至強還帶來了對八通道 DDR5-4800 和 PCIe 5.0 的支持,并包含 CXL 1.1 高速互連總線,可選集成最多 64GB HBM2e 內存。

上述這些針對 IO 和存儲的新技術的引入,使得第四代至強可擴展處理器具備了能夠打破帶寬瓶頸的 I/O 能力,讓使用者可以充分利用處理器的代際性能提升滿足 AI 平臺等業務對于通用算力的苛刻需求。

四代至強可擴展處理器平臺特性

綜合這些基礎芯片架構規模上的升級和革新,以及各種加速器的特定加成效果,第四代至強可擴展處理器的基礎算力相比上一代產品可提升 53%,而其能效,或者說每瓦性能,相比上一代產品也提升了 2.9 倍,這意味著更高的效率,更低的功耗和更優的投資回報率。

英特爾表示,新一代 CPU 還可以催生出前所未有的應用,幫助 AI 算法直接利用非結構化數據進行實時分析。在金融、醫療、零售等行業中,人們可以利用機器學習作出更加精確的投資決策,降低術后并發癥風險,更好地理解消費者的需求。

構建下一代異構AI算力

在不斷尋求創新業務的過程中,人們對于算力的需求相比以往正變得更加迫切。而且這種算力也必須要兼顧到通用和專用的不同方向。因此英特爾架構也正在就此有針對性的演進,這在本次第四代至強可擴展處理器的發布會上就可見一斑 —— 對科學計算和 AI 加速有更苛刻要求的用戶,也等來了英特爾數據中心 GPU 旗艦產品 ——MAX 系列的發布。

其實在過去幾年里,英特爾已經陸續推出了一些異構產品,例如 2022 年英特爾旗下的 Habana Labs 正式發布了用于深度學習訓練的 Gaudi2,隨之被應用在 AWS 上。同年夏天主打視覺云應用的數據中心 GPU Flex 系列也在視頻處理、云游戲和視覺 AI 推理應用中初露頭腳,但很多「發燒級」用戶最期待的還是數據中心 GPU Max 系列,今天,這款采用了突破性設計,采用多芯片集合的方式,混合 5 種工藝,晶體管數量超過千億的 「怪獸」,終于來了!

GPU 產品線的完善,也使得英特爾成為業界唯一一家能提供橫跨 CPU、GPU、ASIC、FPGA 四大類型芯片計算解決方案的供應商,可為智能數據中心提供基于任何場景、需求的產品組合。

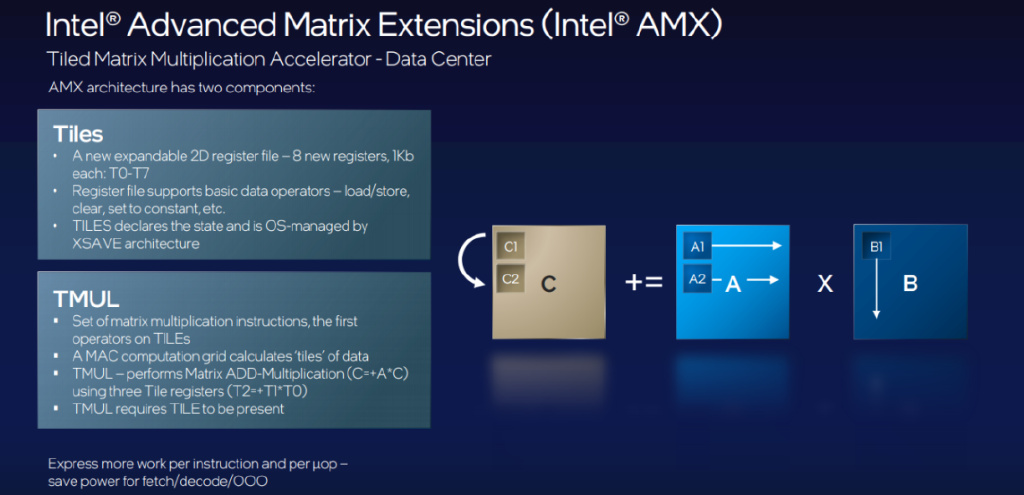

強大的硬件之外,英特爾還利用 oneAPI 軟件體系實現了對異構硬件的統一編程和管理,構建了能夠靈活調配、無縫協作和低門檻的 AI 開發工具。通過 XPU 硬件、oneAPI 軟件及 UCIe 開放標準的布局,英特爾已經打造出了軟硬一體化的完整生態。

隨著新一代芯片發布,我們或許將看到未來 AI 計算的形態發生重要轉變。(來源:機器之心)